1. 序論:バックテストという「完璧な幻想」の崩壊

アルゴリズム取引の世界に深く関わる者であれば、誰もが一度は経験するであろう痛みを伴う瞬間がある。

数ヶ月、あるいは数年にわたる研究開発の末に生み出されたトレーディングAI、いわば自社のアルファを刈り取る鋭利な「矛(ほこ)」が、バックテストにおいて驚異的なパフォーマンスを叩き出す。

エクイティカーブは滑らかに右上方を描き、ドローダウンは最小限に抑えられ、シャープ・レシオは非現実的な数値を記録する。この瞬間、研究者は自らの創造物が市場を制覇する未来を確信する。

しかし、その輝かしいAIが実稼働(ライブ)環境に投入された途端、魔法は解ける。バックテストで描かれた完璧な幻想は無残に崩れ去り、利益は「7月の雪片よりも速く消え去る」1。

期待された利益は損失に変わり、予測不能なドローダウンが資本を蝕む。この現象は、単なる不運や市場の気まぐれではない。

これは、アルゴリズムそのものの論理的欠陥というよりも、むしろ、研究開発と本番稼働という二つの世界の間に横たわる、深く、そしてしばしば見過ごされる断絶に起因する、構造的な失敗なのである。

この問題の根源は、多くのクオンツチームやFinTech企業が、競争優位性の源泉となる「矛」、すなわちトレーディングAIの開発にリソースの大半を注ぎ込む一方で、その「矛」を実戦で有効に機能させるための「盾(たて)」、すなわち本番環境における堅牢な運用・監視・保守のフレームワークを軽視している点にある。

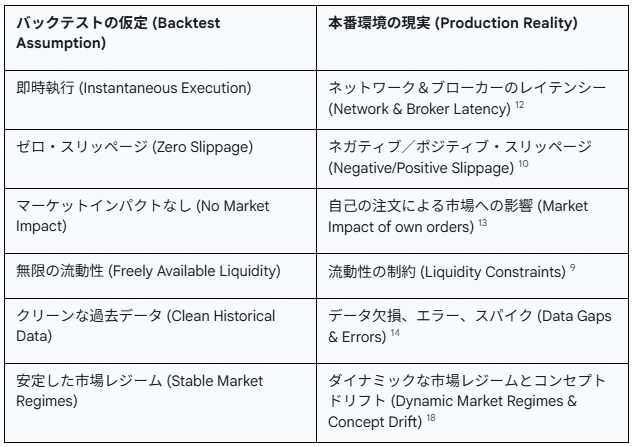

輝かしいバックテストの結果は、あくまで理想化された実験室の中での成功物語に過ぎない。現実の市場は、レイテンシー、スリッページ、データ品質の劣化、そして絶えず変化する市場レジームといった、無数の「摩擦」に満ちた戦場である。

本稿では、この「バックテスト成功、実稼働失敗」という普遍的な課題を深掘りする。単にバックテストの限界を指摘するに留まらず、その失敗がなぜ必然的に起こるのかを構造的に解明し、その上で、この根深い問題を解決するための包括的な処方箋を提示する。

その処方箋こそが、機械学習モデルのライフサイクル全体を管理する工学的規律である「MLOps(Machine Learning Operations)」と、大規模システムの信頼性を担保するGoogle発の思想体系「SRE(Site Reliability Engineering)」の原則を、金融取引という極めて要求の厳しいドメインに特化させて適用することである。

我々AI MQLは、単なるアルゴリズム開発の受託ベンダーではない 2。

我々は、顧客が精魂込めて作り上げた「矛」が、現実の市場で真価を発揮するために不可欠な、最強の「盾」を共創する戦略的パートナーである 2。

本稿を通じて、読者が直面している課題が「アルゴリズムの不具合」ではなく「生産プロセスの未成熟」であることを明らかにし、その解決がいかにして可能であるか、その具体的な設計図を示していく。

2. なぜバックテストは嘘をつくのか?失敗を招く3つの深層構造

バックテストの結果と実稼働のパフォーマンスとの間に乖離が生じるのは、偶然ではない。それは、バックテストという行為そのものが内包する、構造的な欠陥に起因する必然である。

バックテストは未来の市場をシミュレートする魔法の水晶玉ではなく、あくまで過去のデータに対するカーブフィッティング(曲線あてはめ)であり、現実の市場に存在する様々な「摩擦」を無視した、理想化された真空空間での実験に他ならない。

この「バックテストの幻想」を支える3つの深層構造を理解することは、実稼働での失敗を回避するための第一歩である。

2.1. 過学習(オーバーフィッティング)の罠:未来を予測しない過去の記憶

バックテストにおける失敗の最も一般的かつ根深い原因は、過学習(オーバーフィッティング)である 1。

これは、開発されたモデルが、市場の普遍的な法則や一般化可能なシグナルを学習するのではなく、テスト期間中の特定のデータセットにのみ存在するノイズや偶然のパターン、癖といったものを「記憶」してしまう現象を指す 4。

この現象は、あたかもたった一つの複雑なパズル(過去のデータ)を解くためだけに特化した解法を編み出し、他のどんなパズル(未来のライブ市場)にも全く歯が立たない状況に似ている 1。

特に、多数のパラメータや複雑なインジケーターを駆使し、バックテストの成績を最大化するために細心の注意を払って微調整(チューニング)された戦略は、この罠に陥るリスクが極めて高い 1。

バックテストの環境は、このような過剰な最適化に対して、非現実的なほど高いリターンという形で「報酬」を与えてしまうため、開発者は無意識のうちに、実稼働では機能しない、極めて脆弱なモデルを構築する方向へと誘導される。

バックテストで数千パーセントのリターンを示した戦略が、ライブ口座では一瞬にして資金を失うという事例は後を絶たない 4。

これは、金融市場における鉄則、すなわち「過去のパフォーマンスは将来の結果を示すものではない」という事実を、バックテストというプロセスが開発者に忘れさせてしまうことの証左に他ならない 8。

過学習したモデルは、過去を完璧に説明するが、未来を予測する能力は皆無なのである。

2.2. 「摩擦なき世界」の誤謬:レイテンシー、スリッページ、取引コストという現実

バックテストは、物理法則を無視した理想的な世界で実行される。そこでは、発注は瞬時に、そして意図した通りの価格で約定する。

しかし、現実の市場は物理的な制約と経済的なコスト、すなわち「摩擦」に満ちている。

第一に、レイテンシー(Latency)が存在する。

これは、取引システムがシグナルを生成し、注文をブローカーに送信し、それが取引所のマッチングエンジンに到達するまでにかかる時間的な遅延である 10。

特に高頻度取引(HFT)やスキャルピング戦略においては、ミリ秒単位、あるいはマイクロ秒単位の遅延が、利益と損失の分水嶺となり得る 12。バックテストではゼロと仮定されるこの遅延が、現実には常に存在し、絶好の取引機会を陳腐化させる。

第二に、スリッページ(Slippage)が発生する。

これは、注文が執行されるまでの僅かな時間差の間に市場価格が変動することにより、期待した価格と実際に約定した価格との間に生じる差である 10。

特に、重要な経済指標の発表時など、市場のボラティリティが急上昇する局面では、スリッページは著しく拡大する傾向がある 10。

皮肉なことに、多くのアルゴリズムが最大の利益機会を見出すのは、まさにこのようなボラティリティの高い局面であり、バックテストで計算された利益がスリッページによって完全に侵食されることは日常茶飯事である。

第三に、取引コストが無視できない。

これには、ブローカーに支払う手数料やスプレッド、さらには税金などが含まれる 6。

取引頻度が高い戦略ほど、これらのコストは雪だるま式に膨れ上がり、バックテスト上の利益を現実の損失へと転換させる強力な要因となる。

これら「摩擦」の存在は、バックテストが描くクリーンな世界と、現実の取引環境との間に、越えがたい壁が存在することを示している。

2.3. 汚染されたデータ:サバイバーシップ・バイアスとデータ品質という時限爆弾

バックテストの信頼性は、その土台となる過去データの品質に完全に依存する。しかし、多くの開発者が利用するデータは、目に見えない形で「汚染」されており、システム全体に深刻なバイアスをもたらす時限爆弾となり得る 14。

最も悪質なバイアスの一つが、サバイバーシップ・バイアス(生存者バイアス)である 14。

これは、分析対象のデータセットに、現在まで「生き残った」銘柄や資産のみが含まれ、途中で破綻、上場廃止、あるいは合併されたものが除外されてしまう問題である。

例えば、現在のS&P 500構成銘柄の過去データだけを使ってバックテストを行うと、過去にインデックスから除外されたパフォーマンスの悪い企業が分析から抜け落ちるため、結果は必然的に過度に楽観的なものになる。

さらに、一般的なデータ品質の問題も深刻である。欠損値、不正確なタイムスタンプ、異常な価格スパイク(瞬間的な異常値)、誤った出来高データなどは、バックテストの結果に誤ったシグナルを生成し、戦略の有効性を根本から歪めてしまう 14。

興味深いことに、完全に「クリーン」なデータのみで構築・テストされたシステムは、現実世界の不完全なデータストリームに直面した際に、極めて脆弱であることが多い。

ある程度のノイズや不整合を含むデータを用いてテストを行うことは、システムの頑健性(ロバストネス)とアルゴリズムの生存能力を検証する上で、むしろ不可欠なプロセスなのである 17。

これら3つの深層構造、すなわち「過学習」「摩擦なき世界」「汚染されたデータ」は、独立した問題として存在するのではない。

これらは相互に作用し、危険なフィードバックループを形成する。まず、クオンツ分析者は、生存者バイアスを含み、品質に問題のあるデータ(問題2.3)を用いてバックテストを開始する。

次に、この欠陥のあるデータのあらゆるニュアンスを捉えようと、モデルに過剰なパラメータと複雑さを加え、深刻な過学習(問題2.1)を引き起こす。そして、レイテンシーやスリッページといった現実の摩擦を完全に無視したバックテスト環境(問題2.2)が、この過学習に対して壮大で、しかし完全に架空のリターンという形で報酬を与える。

このプロセスは、単に悪いモデルを見抜けなかったというレベルの話ではない。質の悪いデータと非現実的なシミュレーション環境が、積極的に脆弱で過学習したモデルの創出を「奨励」するという、従来のクオンツ研究プロセスに内在する体系的な欠陥なのである。

この構造を理解しない限り、開発者は同じ過ちを無限に繰り返し、実稼働での失敗という運命から逃れることはできない。

表2.1: バックテストの仮定 vs 本番環境の現実

3. MLOps:アルゴリズム取引を「研究」から「事業」へと昇華させる実践哲学

バックテストの幻想から脱却し、実稼働での成功を収めるためには、根本的な発想の転換が求められる。

アルゴリズム取引を、閉ざされた研究室で行われる一連の学術的「研究」として捉えるのではなく、継続的な価値を生み出すための産業的「事業」として再定義する必要があるのだ。

この変革を実現するための実践的な哲学であり、工学的な規律こそが「MLOps(Machine Learning Operations)」である 19。

MLOpsは、単一のツールや特定のテクノロジーを指す言葉ではない。それは、機械学習モデルのライフサイクル全体、すなわちアイデアの創出からデータ準備、モデル開発、テスト、デプロイメント、本番環境での監視、そして再学習と廃棄に至るまでの一連のプロセスを、体系的かつ自動化された手法で管理するための文化、原則、そして実践の総体である。

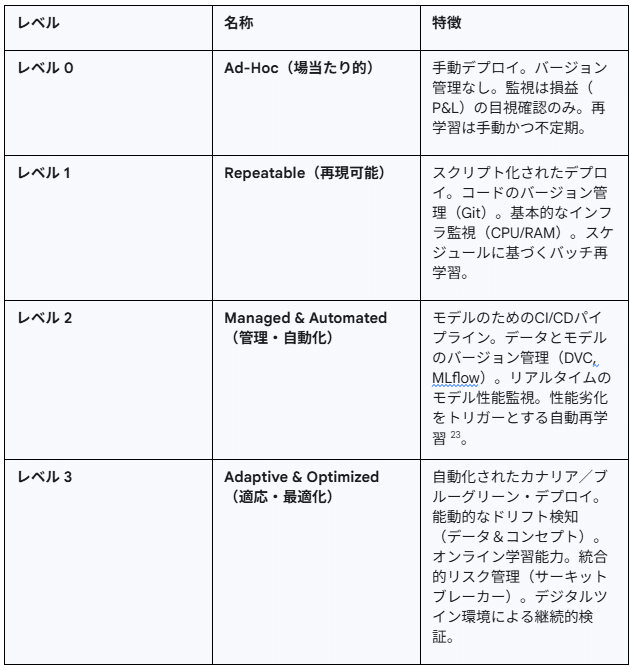

多くのクオンツチームでは、モデルの開発と運用が分断されている。データサイエンティストがモデルを開発し、それを手作業でIT運用チームに引き渡す。このプロセスは場当たり的で、再現性がなく、ヒューマンエラーの温床となる 19。

モデルのバージョン管理は曖昧で、どのデータでどのモデルが学習されたのかを追跡することは困難を極める。このようなアプローチは、モデルの数が少なく、更新頻度が低い場合にはなんとか機能するかもしれない。しかし、高度なトレーディングAIのように、市場の変化に迅速に対応し、常に最高のパフォーマンスを維持する必要があるシステムにおいては、スケーラビリティの欠如、手作業に起因するエラーリスクの増大、そしてデータサイエンスチームとIT運用チーム間の連携不足といった深刻な問題を引き起こす 19。

MLOpsは、これらの課題に対して、自動化され、再現可能で、スケーラブルなワークフローを導入することで解決策を提示する。これは、AI MQLが提供するような、個人のフリーランス開発者の能力を遥かに超えた、プロフェッショナルで構造化されたパートナーシップの価値そのものである 2。

しかし、ここで極めて重要な点を指摘しなければならない。金融市場におけるMLOpsは、Eコマースの推薦システムや画像認識といった他の産業分野のMLOpsとは、その性質が根本的に異なる。

一般的なMLOpsが対象とする環境は、ユーザーの行動が比較的ゆっくりと変化する、ある程度「静的」な世界である。対照的に、金融市場は本質的に「非定常的(non-stationary)」である。つまり、データを生成する根源的なプロセスそのものが、常に予測不能な形で変化し続けている 8。

さらに、市場は「敵対的(adversarial)」な環境である。他の市場参加者は、あなたの戦略が利用するパターンを積極的に見つけ出し、それを逆手に取って利益を得ようと試みる。したがって、金融取引におけるMLOpsは、単なる「デプロイして監視する(deploy and monitor)」という単純なプラクティスではあり得ない。それは、「デプロイし、監視し、検証し、適応し、そして防御する(deploy, monitor, validate, adapt, and defend)」という、絶え間ない動的なサイクルでなければならない。

この金融市場特有の要求は、他のどのドメインよりもはるかに高い頻度での監視、より洗練されたドリフト(性能劣化)検知メカニズム、そしてリスク管理システムとのより緊密な統合を必要とする。この認識こそが、次章で詳述する、金融市場に特化したMLOpsアーキテクチャを設計する上での基本思想となる。それは、汎用的なMLOpsのベストプラクティスを、金融という特殊な戦場で勝ち抜くために先鋭化させた、専門的な知識体系なのである。

4. 本番環境で「矛」を研ぎ澄ます:金融市場特化型MLOpsの設計図

理論から実践へ。本章では、金融市場の過酷な要求に応えるために特化設計された、本番稼働グレードのMLOpsアーキテクチャの具体的な設計図を提示する。

これは、単なるツールの羅列ではなく、トレーディングAI(矛)がその性能を最大限に発揮し、かつ維持し続けるための体系的なフレームワークである。この設計図の各コンポーネントは、AI MQLが提供する高度なコンサルティングと実装サービスの核心をなすものであり、潜在的なクライアントが自社の現状を評価し、より成熟したシステムへの道筋を明確に理解するための指針となる。

まず、組織のMLOps成熟度を自己評価するためのモデルを以下に示す。多くの組織はレベル0またはレベル1に留まっており、レベル3への到達は、専門的なパートナーシップなくしては極めて困難である。

表4.1: 金融トレーディングにおけるMLOps成熟度モデル

4.1. 観測可能性の確立:PrometheusとGrafanaによるリアルタイム・ダッシュボード

あらゆる高度な制御システムの第一歩は、その内部状態を正確に把握すること、すなわち「観測可能性(Observability)」の確立である。

MLOpsフレームワークにおいて、これはシステム全体の神経系を構築することに等しい。この目的のために、業界標準となっているオープンソースの組み合わせが、PrometheusとGrafanaである。

Prometheusは、もともとSoundCloudで開発された時系列データベースであり、システムからメトリクス(性能指標)を収集・保存する役割を担う 24。MT5上で稼働するトレーディングAI(EA)のコード内に、Prometheusのクライアントライブラリ(例えばPythonクライアント)を用いて「計装(instrumentation)」を施す 26。これにより、以下のようなカスタムメトリクスをHTTPエンドポイント経由で公開(expose)する。

- prediction_requests_total: 予測リクエストの総数をカウントするカウンター。

- prediction_latency_seconds: 予測処理にかかる時間を記録するヒストグラム。

- order_execution_errors_total: 発注失敗の総数をカウントするカウンター。

- model_prediction_value: モデルが出力した予測値そのものを記録するゲージ。

Grafanaは、このPrometheusに蓄積された時系列データをデータソースとして接続し、強力でインタラクティブなダッシュボードを構築するための可視化ツールである 28。

Grafanaダッシュボード上では、Prometheusのクエリ言語であるPromQLを用いて、収集したメトリクスをリアルタイムで可視化する。例えば、rate(prediction_latency_seconds_sum[1m]) / rate(prediction_latency_seconds_count[1m])といったクエリを使えば、過去1分間の平均予測レイテンシーをグラフに表示できる 26。

このPrometheusとGrafanaの組み合わせにより、トレーディングシステムの技術的な健全性(CPU使用率、メモリ消費量)から、ビジネスロジックの性能(予測レイテンシー、エラーレート)まで、あらゆる側面をリアルタイムで一元的に監視する基盤が確立される。

これは、後述するドリフト検知やアラート、リスク管理のすべての前提となる、不可欠な第一層である。

4.2. 静かなる性能劣化との戦い:データドリフトとコンセプトドリフトの検知と対策

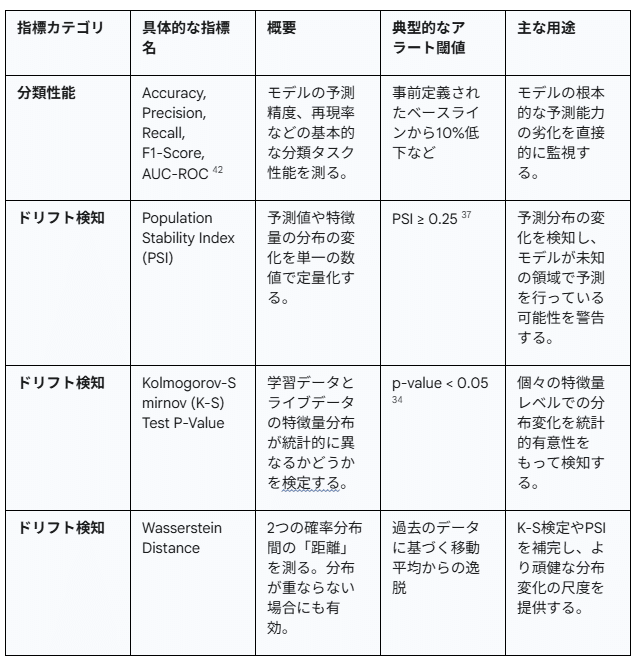

本番環境にデプロイされたMLモデルは、たとえ技術的な障害が発生していなくても、その予測性能が時間と共に静かに、しかし確実に劣化していくという宿命を負っている。この現象は「モデルドリフト」として知られ、トレーディングAIの「静かなる殺し屋」とも言える存在である 30。モデルドリフトは、主に二つの種類に大別される。

- データドリフト(Data Drift): これは、モデルへの入力データ(特徴量)の統計的分布が、学習時とは変化してしまう現象である(数学的には$P(X)$の変化)18。例えば、市場のボラティリティが低い時期のデータで学習したモデルが、突如として高ボラティリティの市場環境に直面した場合、入力特徴量の分布が大きく変化し、モデルの性能が低下する可能性がある。

- コンセプトドリフト(Concept Drift): こちらはより深刻で、入力データと予測対象(ターゲット変数)との間の根源的な関係性そのものが変化してしまう現象である(数学的には$P(Y|X)$の変化)31。例えば、過去のデータでは特定の経済指標の発表が市場の上昇に繋がっていた(という関係性をモデルが学習した)が、中央銀行の金融政策の変更により、同じ指標の発表が市場の下落を引き起こすようになった場合、コンセプトドリフトが発生したと言える。2008年の金融危機以前のデータで学習されたモデルが、2023年の地方銀行危機において全く機能しなくなったという報告は、この典型例である 33。

これらのドリフトを放置することは、バックテストで確認されたエッジを徐々に失い、最終的には戦略を機能不全に陥らせる。したがって、MLOpsフレームワークには、これらのドリフトを定量的に検知し、警告を発するメカニズムが不可欠である。そのために、以下のような高度な統計的手法が用いられる。

- コルモゴロフ–スミルノフ検定(K-S検定): 2つのデータサンプルの累積分布関数を比較し、それらが同じ分布から来ているかどうかを検定するノンパラメトリックな手法。学習データの特徴量分布と、ライブデータのストリームから得られる特徴量分布を比較し、検定のp値が事前に定めた有意水準(例:0.05)を下回った場合にドリフトと判断する 34。

- 人口安定性指数(Population Stability Index, PSI): 2つの分布の差異を単一の数値で定量化する指標。特に金融業界の信用スコアリングモデルのモニタリングで広く用いられている。学習データとライブデータの予測値(または特徴量)の分布をそれぞれ10個程度のビン(階級)に分割し、各ビンにおけるレコードの割合を比較して算出する。一般的に、PSIが0.1未満であれば変化なし、0.1から0.25であれば軽微な変化、0.25以上であれば重大な変化(ドリフト)と解釈され、モデルの再学習を検討するトリガーとなる 36。PSIの計算式は以下の通りである。

$$ PSI = \sum (% \text{Actual} – % \text{Expected}) \times \ln\left(\frac{% \text{Actual}}{% \text{Expected}}\right) $$ - ワッサースタイン距離(Wasserstein Distance): 「土砂移動距離(Earth Mover’s Distance)」とも呼ばれ、一方の確率分布をもう一方の確率分布に変換するために必要な「仕事量」の最小値を測ることで、分布間の距離を定量化する。KLダイバージェンスなどの他の指標と比較して、分布が重ならない場合でも意味のある距離を計算できるという利点がある 39。

これらの統計量をリアルタイムで計算し、Grafanaダッシュボード上で可視化・監視することで、「モデルの性能が静かに劣化している」という、これまで捉えどころのなかった現象を、客観的なデータに基づいて管理することが可能になる。

表4.2: モデル性能劣化を監視するための主要指標

4.3. 継続的検証のフロンティア:「デジタルツイン」による並列リアルタイム・シミュレーション

バックテストが過去のデータに対する静的な検証であるのに対し、実稼働環境は未来の未知のデータに対する動的な挑戦である。

このギャップを埋めるための究極的なソリューションとして注目されるのが、「デジタルツイン」という先進的なコンセプトである。

デジタルツインとは、単に物理的なオブジェクトの仮想的なレプリカを指すだけではない 44。

金融取引の文脈におけるデジタルツインは、トレーディングシステム全体のエコシステムの高忠実度な仮想的複製を意味する。これには、取引アルゴリズムそのものだけでなく、マーケットデータフィード、取引所への接続性、注文執行ロジック、さらには社内のインフラストラクチャ構成までが含まれる 46。

このデジタルツインは、現実世界の物理的な counterpart からリアルタイムで継続的にデータを受け取り、常に最新の状態に同期される 48。このアーキテクチャがもたらす最大の価値は、リスクを伴わずに、極めて現実的な環境で継続的な検証とシミュレーションを実行できる点にある。

- 並列リアルタイム検証: 本番環境で稼働しているトレーディングAIと全く同じアルゴリズムを、デジタルツイン環境内で並列に実行する。ライブのマーケットデータを同時に受信し、デジタルツイン内で仮想的な注文を生成・執行する。これにより、実際の資金をリスクに晒すことなく、現在の市場環境に対してモデルがどのように反応するかを継続的に検証できる 50。バックテストでは決して再現不可能な「今、この瞬間」の市場に対するモデルの性能を、リアルタイムで評価することが可能になる。

- 高度な「What-If」シナリオ分析: デジタルツイン環境を用いることで、様々な「もしも」のシナリオを安全にテストできる。例えば、「もし市場が10分で20%暴落したら(フラッシュ・クラッシュ)、このアルゴリズムはどのように振る舞うか?」といったストレステストや、「新しいリスク管理モジュールを導入した場合、システム全体のレイテンシーにどのような影響が出るか?」といった影響分析を、本番システムに一切影響を与えることなく実施できる 51。

デジタルツインは、バックテストの「過去を見る」という制約と、ペーパートレードの「現実との乖離」という問題を同時に克服する。それは、未来の可能性を探るための、生きた実験室なのである。

この環境を構築し、継続的な検証プロセスを自動化することは、モデルの信頼性を最高レベルに維持するための、次世代の標準的プラクティスとなるだろう。

4.4. 安全なデプロイメント戦略:カナリア・リリースとA/Bテストによるモデルの段階的投入

新しいバージョンのトレーディングAIを開発し、その優位性をデジタルツイン環境で確認できたとしても、それを一気に本番環境の旧バージョンと入れ替える行為は、極めて高いリスクを伴う 53。

未知のバグや予期せぬ挙動が、大規模な損失を引き起こす可能性があるからだ。このリスクを管理し、安全に新モデルを導入するために、段階的なロールアウト戦略が採用される。

- カナリア・リリース(Canary Release): この手法は、かつて炭鉱で有毒ガスを検知するためにカナリアを連れて行った逸話に由来する。新しいバージョンのモデル(カナリア)を、まずごく一部のユーザーやトラフィック(例えば、全体の5%)にのみ適用する 54。この小さなグループのパフォーマンス(レイテンシー、エラーレート、損益など)を注意深く監視し、問題がないことを確認できた場合にのみ、徐々に適用範囲を10%、50%、そして100%へと拡大していく。もしカナリアグループで問題が検知されれば、即座にロールバックを行い、影響を最小限に食い止めることができる 53。

- A/Bテスト: カナリア・リリースが主にリスク軽減と安定性確認に焦点を当てるのに対し、A/Bテストはより進んだ形で、複数のモデルバージョンのパフォーマンスを統計的に比較検証することを目的とする 56。本番トラフィックをランダムに複数のグループに分割し、一方のグループ(A)には既存のモデルを、もう一方のグループ(B)には新しいモデルを適用する。そして、一定期間にわたって、損益、スリッページ、約定率といったビジネス上重要なKPIをグループ間で比較する。これにより、「新しいモデルは、統計的に有意な差をもって既存モデルよりも優れているか?」という仮説を、実データに基づいて検証することが可能になる 53。

これらの安全なデプロイメント戦略は、CI/CD(継続的インテグレーション/継続的デリバリー)パイプラインに組み込まれ、モデルの更新プロセスを自動化し、ヒューマンエラーを排除する。これにより、アジャイルなモデル改善サイクルを、安全性を担保しながら高速に回すことが可能となる。

4.5. 磐石な基盤の構築:IaCとSRE原則に基づく低遅延・高信頼性インフラ

これまで述べてきたMLOpsの高度な実践はすべて、その土台となるインフラストラクチャが磐石であって初めて意味をなす。

トレーディングシステム、特に低遅延が要求される環境では、インフラの信頼性、一貫性、そしてスケーラビリティが成功の絶対条件である。この磐石な基盤を構築するために、2つの現代的なエンジニアリング思想が導入される。

- Infrastructure as Code (IaC): これは、サーバー、ネットワーク、ストレージといったインフラ構成を、手作業ではなく、コード(例えば、TerraformやAWS CloudFormationの定義ファイル)によって管理するプラクティスである 58。IaCを導入することで、開発、テスト、本番といった複数の環境を、寸分違わず同一の構成で、かつ自動で構築することが可能になる。これにより、「私の開発環境では動いたのに、本番では動かない」といった「環境ドリフト」の問題を根絶し、デプロイメントの再現性と信頼性を劇的に向上させる 60。インフラの変更はすべてコードの変更としてバージョン管理され、レビュープロセスを経るため、属人的で追跡不可能な手作業による設定変更が排除される 61。

- サイト信頼性エンジニアリング(Site Reliability Engineering, SRE): SREは、システムの信頼性をデータに基づいて定量的に管理するための体系的なアプローチである 62。SREの中心的な概念は以下の通りである。

- SLO(Service Level Objective, サービスレベル目標): ユーザーにとって意味のある、具体的な信頼性の目標値。「注文執行成功率99.9%」や「95パーセンタイルAPI応答時間200ミリ秒未満」のように、測定可能な指標として定義される 63。

- エラーバジェット(Error Budget): SLOから導き出される、許容される不信頼性の量。例えば、SLOが99.9%であれば、エラーバジェットは0.1%となる。開発チームは、このエラーバジェットの範囲内であれば、新機能のリリースなど、リスクを伴う変更を積極的に行うことができる。しかし、エラーバジェットを使い果たしてしまえば、新たな機能開発は凍結され、チームは信頼性の改善に集中しなければならない 63。

IaCとSREの原則を組み合わせることで、トレーディングインフラは、単なるサーバーの集合体から、信頼性が定量的に管理され、コードによって再現可能で、ビジネスの要求に応じて俊敏に変更可能な、生きたシステムへと進化する。

これらMLOpsの各コンポーネントは、独立した選択肢のメニューではない。それらは、強固な依存関係で結ばれた、一つの統合されたシステムを形成する。IaC/SREによる磐石な基盤(4.5)がなければ、観測可能性(4.1)で得られるデータは信頼できない。

観測可能性がなければ、ドリフト(4.2)を検知することも、カナリア・リリース(4.4)を評価することも、デジタルツイン(4.3)を検証することもできず、盲目な状態で運用することになる。正確なドリフト検知がなければ、モデルがいつ負債に転じたかを知る術がなく、あらゆるデプロイ戦略はロシアンルーレットと化す。

安全なデプロイ戦略がなければ、完璧に検証された新モデルでさえ、不適切なロールアウトによって大惨事を引き起こしかねない。そして、デジタルツインは、これらすべてのレイヤーにフィードバックを提供する究極の検証層として機能する。

この相互依存性は、断片的なアプローチが失敗する運命にあることを示唆している。成功への唯一の道は、AI MQLが提供するような、全体論的で統合されたシステムを構築することなのである 2。

5. 「矛」と「盾」の共生:トレーディングAIと統合的リスク管理の融合

これまで詳述してきたMLOpsフレームワークは、単なる技術的な安定運用のためのツールセットではない。

それは、トレーディングAIの運用リスクをリアルタイムで定量化し、能動的に制御するための、新世代のリスク管理システムそのものである。このシステムにおいて、トレーディングAIである「矛」と、MLOps/SREによる運用基盤である「盾」は、単に共存するだけでなく、互いの価値を高め合う「共生的」な関係を築く。

この統合的リスク管理の核心は、MLOpsシステムが生成する「観測可能性」のデータを、直接的なリスク制御のトリガーとして活用することにある。

- 自動化されたサーキットブレーカー:

市場全体に適用されるサーキットブレーカー制度と同様の概念を、個別のトレーディング戦略レベルで実装する 64。前章で構築した監視システムが、事前に定義された異常を検知した場合、自動的にシステムの安全装置を作動させる。

例えば、特定の重要特徴量のPSIが危険水域である0.25を超えた場合、あるいはモデルの予測レイテンシーがSLOを逸脱した場合、これをトリガーとして、当該アルゴリズムの新規発注を自動的に停止したり、既存ポジションのサイズを強制的に縮小したりする「サーキットブレーカー」を発動する 65。

このメカニズムは、2012年にKnight Capital社が約45分で4億4000万ドルもの損失を出したような、単一のアルゴリズムの暴走が企業全体を危機に陥れる事態を防ぐための、極めて強力な防衛線となる 33。 - モデル信頼度に基づく動的ポジションサイジング:

モデルの「自信」は常に一定ではない。市場環境やデータの質によって、その予測の信頼度は刻一刻と変化する。

この信頼度をポジションサイズに反映させることで、リスク管理をより動的かつインテリジェントなものに進化させることができる。

具体的には、モデルが出力する予測確率の高さや、MLOps監視システムが報告するドリフトスコアの低さ(安定性)といった指標を「モデル信頼度スコア」として統合的に評価する。

信頼度スコアが高い局面では、事前に定められたリスク許容度の範囲内でポジションサイズを拡大し、逆にスコアが低い(モデルが不確実な、あるいは不安定な状態にある)局面では、自動的にポジションサイズを縮小、あるいは取引を見送る 68。

これにより、リスク管理は静的な事前計算から、リアルタイムのフィードバックループへと変貌を遂げる。 - 全社的リスク管理システムとの統合:

個別戦略のMLOpsダッシュボードやアラートは、エンジニアリングチームのサイロに留まるべきではない。

それらは、企業全体の統合リスク管理部門やコンプライアンス部門がアクセスすべき、第一級の情報源となるべきである 7。

Grafanaダッシュボードは、自動化されたトレーディング・ポートフォリオ全体の「オペレーショナル・リスク」をリアルタイムで可視化する計器盤として機能し、リスク管理者に前例のないレベルの透明性と洞察を提供する 73。

これにより、技術的なモデルリスクと、財務的な市場リスクを、一つの統合されたビューで管理することが可能になる。

この「矛」と「盾」の融合は、単なるリスク軽減に留まらない、強力な価値創造のサイクル、すなわち「フライホイール効果」を生み出す。まず、堅牢なリスク管理フレームワーク(盾)の中で安全に運用されるトレーディングAI(矛)は、安定したパフォーマンスを発揮する。

その安定した運用から得られる、レイテンシー、スリッページ、ドリフト指標といったリアルタイムのオペレーショナルデータは、いかなるバックテストも提供し得ない、極めて価値の高い「生きた情報」である。

これこそが、AI MQLの事業戦略における「派生的知見(derivative knowledge)」に他ならない 2。この貴重な知見は、現在のAIモデルをさらに洗練させるだけでなく、次世代のより頑健で高性能な戦略を開発するための、この上ないインプットとなる。

そして、より優れた戦略は、より質の高いオペレーショナルデータを生み出し、それがさらなる知見へと繋がる。

このようにして、卓越した運用(盾)がアルファ創出(矛)を直接的に駆動し、その逆もまた然りという、自己強化的な好循環が生まれる。

これは、AI MQLが提唱する「共生的R&Dモデル」の強力な実証であり、我々のパートナーシップが提供する独自の価値の根源なのである 2。

6. 結論:技術的負債から戦略的資産へ

本稿で論じてきた「バックテスト成功、実稼働失敗」という問題は、単なる技術的な不整合や個別のミスに起因するものではない。

それは、アルゴリズム取引の運用側面、すなわちデプロイメント、監視、検証、リスク管理といった一連のプロセスを軽視することによって組織内に静かに蓄積されていく、巨大な「技術的負債」の顕在化である 60。

この負債は、最も優れた数学的才能と計算資源を投じて開発された、いかなる高度なトレーディングAI(矛)をも、実戦の場では無価値なものに変えてしまう力を持つ。なぜなら、AIの知性が発揮される以前の段階で、インフラの不安定性、データの汚染、市場環境との不一致といった根本的な問題が、その性能を根こそぎ奪い去ってしまうからだ。

多くの組織は、新たなアルファの探求という魅力的な活動に目を奪われ、この目に見えない負債が複利で膨れ上がっていることに気づかない。

そして、実稼働での手痛い失敗という形で、その満期一括返済を迫られるのである。

しかし、この課題に対する我々の処方箋、すなわち金融市場に特化したMLOpsとSRE原則に基づく包括的なフレームワークは、この技術的負債を返済するだけでなく、それを組織にとって最も価値のある「戦略的資産」へと転換させる力を持つ。

堅牢なMLOps/SRE基盤(盾)への投資は、単なるコストセンターへの支出ではない。それは、高い潜在能力を秘めつつも、本質的に不安定でリスクの高い研究開発プロジェクト(矛)を、信頼性が高く、スケーラブルで、継続的に自己改善していく強力な事業資産へと変貌させるための、必要不可欠な変革プロセスなのである。この変革は、ドリフトをリアルタイムで検知し、サーキットブレーカーで損失を防ぎ、デジタルツインで未来をシミュレートし、得られた知見を次の戦略へとフィードバックする、生きたエコシステムを構築することに他ならない。

このような高度なエコシステムの構築と運用は、アルゴリズム設計とは全く異なる、専門的な知識と経験を要求する。

それは、ソフトウェアエンジニアリング、データサイエンス、金融工学、そしてシステム運用の各分野にまたがる、極めて学際的な専門性である。現代の複雑かつ競争の激しい定量的取引の世界において、この変革を独力で達成することは、もはや現実的ではない。

成功への鍵は、AI MQLが提唱するような、単なる技術提供者ではなく、顧客と共に具体的な価値を「共創」する戦略的パートナーとの連携にある 2。

我々の役割は、コードを納品することではない。顧客の持つ鋭利な「矛」が、我々の提供する強固な「盾」と一体となることで、市場で持続的な競争優位性を確立するための、信頼できる道標となることである。技術的負債を戦略的資産へ。

その変革の旅路こそが、我々が顧客と共に歩む道なのである。

引用文献

- Why Overfitting Is a Risk to Your Algo Trading Success and How to Combat It – uTrade Algos, https://www.utradealgos.com/blog/why-overfitting-is-a-risk-to-your-algo-trading-success-and-how-to-combat-it

- AI MQL

- Why Back-tested Strategies Fail in Live Trading and How to Fix It – Quantman, https://www.quantman.in/ghostblog/why-back-tested-strategies-fail-in-live-trading-and-how-to-fix-it/

- What is Overfitting in Trading? – AlgoTrading101 Blog, https://algotrading101.com/learn/what-is-overfitting-in-trading/

- What Is Overfitting in Algorithmic Trading? – Bookmap, https://bookmap.com/blog/what-is-overfitting-in-algorithmic-trading

- What to Do When Your Live Algo Trades Don’t Perform as Expected | Tradetron Blog, https://tradetron.tech/blog/what-to-do-when-your-live-algo-trades-dont-perform-as-expected

- What Is Overfitting in Trading Strategies? – LuxAlgo, https://www.luxalgo.com/blog/what-is-overfitting-in-trading-strategies/

- Reason why algo do well on backtest but blows in real account : r/algotrading – Reddit, https://www.reddit.com/r/algotrading/comments/1lvcb2f/reason_why_algo_do_well_on_backtest_but_blows_in/

- Backtesting vs Live Trading: Key Factors for a Successful Algo Strategy, https://www.hashstudioz.com/blog/backtesting-vs-live-trading-key-factors-for-a-successful-algo-strategy/

- Execution Latency and Slippage – Impact on Forex Trading Performance – Hola Prime, https://holaprime.com/blogs/trading-education/execution-latency-slippage-impact-on-forex-trading/

- Trading Latency Optimization Guide – Blog – TradersPost, https://blog.traderspost.io/article/trading-latency-optimization-guide

- How VPS Latency Impacts Algorithmic Trading – QuantVPS, https://www.quantvps.com/blog/how-vps-latency-impacts-algorithmic-trading

- What is Slippage in Automated Trading? and Methodologies to Reduce Slippages – Algomojo, https://algomojo.com/blog/what-is-slippages-in-automated-trading-and-methodologies-to-reduce-slippages/

- The Importance Of Data Quality In Backtesting For Trading – mastertrust, https://www.mastertrust.co.in/blog/the-importance-of-data-quality-in-back-testing-for-trading

- What Is Backtesting & How to Backtest a Trading Strategy Using Python – QuantInsti, https://www.quantinsti.com/articles/backtesting-trading/

- Backtesting in Trading (2025): Mechanics, Pros, Cons, https://thetradinganalyst.com/what-is-backtesting-in-trading/

- “quality” data for backtesting : r/algotrading – Reddit, https://www.reddit.com/r/algotrading/comments/1o140u1/quality_data_for_backtesting/

- Data Drift vs Concept Drift. I understand that learning data science… | by Hey Amit | Data Scientist’s Diary | Medium, https://medium.com/data-scientists-diary/data-drift-vs-concept-drift-0b1a7d59ebb0

- What is MLOps? Benefits, Challenges & Best Practices – lakeFS, https://lakefs.io/mlops/

- What is MLOps? | Google Cloud, https://cloud.google.com/discover/what-is-mlops

- MLOps Definition and Benefits | Databricks, https://www.databricks.com/glossary/mlops

- MLOps Challenges and How to Face Them – neptune.ai, https://neptune.ai/blog/mlops-challenges-and-how-to-face-them

- 8. Continuous training – AWS Prescriptive Guidance, https://docs.aws.amazon.com/prescriptive-guidance/latest/mlops-checklist/training.html

- Prometheus Monitoring OSS | Store large amounts of metrics – Grafana, https://grafana.com/oss/prometheus/

- Prometheus – Monitoring system & time series database, https://prometheus.io/

- Real-Time Model Monitoring with Prometheus & Grafana | by Rakesh Thakur – Medium, https://medium.com/@tunamuna29/real-time-model-monitoring-with-prometheus-grafana-da7f0686d85f

- valohai/prometheus-client-python – GitHub, https://github.com/valohai/prometheus-client-python

- What is Prometheus? | Grafana documentation, https://grafana.com/docs/grafana/latest/fundamentals/intro-to-prometheus/

- Building Real-Time Dashboards with Grafana – DEV Community, https://dev.to/rebecca_tao_651f5198fd9ea/building-real-time-dashboards-with-grafana-36pl

- The Silent Killer: How Model Drift is Sabotaging Production AI Systems – InsightFinder, https://insightfinder.com/blog/model-drift-ai-observability/

- Understanding Data Drift vs. Concept Drift in Machine Learning – InsightFinder, https://insightfinder.com/blog/machine-learning-data-drift-vs-concept-drift/

- Data Drift vs. Concept Drift: What Is the Difference? – Dataversity, https://www.dataversity.net/articles/data-drift-vs-concept-drift-what-is-the-difference/

- When Algorithms Go Wrong: The Growing Crisis in Financial AI – Medium, https://medium.com/@cliu2263/when-algorithms-go-wrong-the-growing-crisis-in-financial-ai-f9da05adf377

- Understanding Data Drift and Model Drift: Drift Detection in Python – DataCamp, https://www.datacamp.com/tutorial/understanding-data-drift-model-drift

- Detecting Data Drift w/ The Kolmogorov-Smirnov (KS) Test in ML, MLOps & AI #machinelearning – YouTube, https://www.youtube.com/watch?v=8BAuZjrrUAI

- All About Population Stability Index (PSI) | by JO – Medium, https://medium.com/@zzzoujing/all-about-population-stability-index-psi-a0de5ee77318

- population stability index (PSI) – Matthew Burke’s Blog, https://mwburke.github.io/data%20science/2018/04/29/population-stability-index.html

- Population Stability Index and Characteristic Analysis – ListenData, https://www.listendata.com/2015/05/population-stability-index.html

- The Wasserstein Distance For Dummies | by Govind – Medium, https://medium.com/@mynameisgovind/the-wasserstein-distance-for-dummies-be14162c7c30

- How to test Machine Learning Models? Numerical data drift – Giskard, https://www.giskard.ai/knowledge/how-to-test-ml-models-3-n-numerical-data-drift

- Measuring Data Drift with KL Divergence and Wasserstein Distance – YouTube, https://www.youtube.com/watch?v=nazEb6lvb7o

- What Are Machine Learning Performance Metrics? – Pure Storage, https://www.purestorage.com/knowledge/machine-learning-performance-metrics.html

- Performance Metrics in Machine Learning [Complete Guide] – neptune.ai, https://neptune.ai/blog/performance-metrics-in-machine-learning-complete-guide

- Digital Twins and Artificial Intelligence: A Powerful Combination – CTO Magazine, https://ctomagazine.com/digital-twin-and-ai-a-powerful-combination/

- Industrial applications of digital twins | Philosophical Transactions of the Royal Society A, https://royalsocietypublishing.org/doi/10.1098/rsta.2020.0360

- How Digital Twin Technology Could Help Us Predict the Future: Karen Willcox, https://ctomagazine.com/digital-twin-technology-ted-talk-by-karen-willcox/

- What Is a Digital Twin? | IBM, https://www.ibm.com/think/topics/digital-twin

- A Conceptual Framework for Digital Twin Deployment in Real-Time Monitoring of Mechanical Systems – ResearchGate, https://www.researchgate.net/publication/392282725_A_Conceptual_Framework_for_Digital_Twin_Deployment_in_Real-Time_Monitoring_of_Mechanical_Systems

- The Applications and Challenges of Digital Twin Technology in Smart Grids: A Comprehensive Review – MDPI, https://www.mdpi.com/2076-3417/14/23/10933

- (PDF) Validation of Digital Twins: Challenges and Opportunities – ResearchGate, https://www.researchgate.net/publication/366325833_Validation_of_Digital_Twins_Challenges_and_Opportunities

- From what-if to why not: How real-time digital twins transform customer experience – Ciena – Blue Planet, https://www.blueplanet.com/blog/2025/from-what-if-to-why-not-how-real-time-digital-twins-transform-customer-experience

- (PDF) DIGITAL TWIN ARCHITECTURES FOR REAL-TIME FINANCIAL STRESS TESTING IN AI-POWERED ERP SYSTEMS – ResearchGate, https://www.researchgate.net/publication/391666574_DIGITAL_TWIN_ARCHITECTURES_FOR_REAL-TIME_FINANCIAL_STRESS_TESTING_IN_AI-POWERED_ERP_SYSTEMS

- Day 60/100: Canary Deployments and A/B Testing – Safer, Smarter Model Rollouts, https://medium.com/@sebuzdugan/day-60-100-canary-deployments-and-a-b-testing-safer-smarter-model-rollouts-d9245042baf9

- What are Canary Tests and How do They Work? – Datadog, https://www.datadoghq.com/knowledge-center/canary-testing/

- A complete guide to canary testing – Qase, https://qase.io/blog/canary-testing/

- MLREL-11: Use an appropriate deployment and testing strategy – Machine Learning Lens, https://docs.aws.amazon.com/wellarchitected/latest/machine-learning-lens/mlrel-11.html

- Canary vs. A/B release strategy – Stack Overflow, https://stackoverflow.com/questions/62092338/canary-vs-a-b-release-strategy

- What is Infrastructure as Code? – IaC Explained – AWS, https://aws.amazon.com/what-is/iac/

- What is Infrastructure as Code (IaC) – Red Hat, 10月 26, 2025 https://www.redhat.com/en/topics/automation/what-is-infrastructure-as-code-iac

- What is infrastructure as code (IaC) – Azure DevOps | Microsoft Learn, https://learn.microsoft.com/en-us/devops/deliver/what-is-infrastructure-as-code

- Infrastructure as Code (IaC) Best Practices (+ Digital Payment Platform Case Overview), https://gartsolutions.com/infrastructure-as-code-iac-best-practices-digital-payment-platform-case-overview/

- 10 Essential SRE Principles for Reliable Systems – SigNoz, https://signoz.io/guides/sre-principles/

- What is SRE? Complete guide to site reliability engineering tools and practices – DX, https://getdx.com/blog/site-reliability-engineering/

- What Is a Circuit Breaker in Trading? How Is It Triggered? – Investopedia, https://www.investopedia.com/terms/c/circuitbreaker.asp

- Circuit Breaker Pattern – Azure Architecture Center | Microsoft Learn, https://learn.microsoft.com/en-us/azure/architecture/patterns/circuit-breaker

- Circuit Breaker design pattern in the distributed system | by Shishir Mohire – Medium, https://medium.com/@shishirmohire/circuit-breaker-design-pattern-in-the-distributed-system-a6eca56ded92

- Systemic failures and organizational risk management in algorithmic trading: Normal accidents and high reliability in financial markets – PubMed Central, https://pmc.ncbi.nlm.nih.gov/articles/PMC8978471/

- What is Position Sizing? The Magic Formula for Capital Preservation, https://fenefx.com/en/blog/explanatory-position-size/

- Position Sizing Methods: 7 Proven Techniques for Smart Trading Risk Management, https://tradefundrr.com/position-sizing-methods/

- Lesson #5 Achieving Your Goals Through Position-Sizing – MarketMates, https://marketmates.com/learn/forex-course/lesson-5-achieving-your-goals-through-position-sizing/

- What Is Model Risk Management? – IBM, https://www.ibm.com/think/topics/model-risk-management

- (PDF) Integration of Machine Learning Algorithms for Real-Time Risk Assessment in Financial Trading Systems – ResearchGate, https://www.researchgate.net/publication/383945972_Integration_of_Machine_Learning_Algorithms_for_Real-Time_Risk_Assessment_in_Financial_Trading_Systems

- Machine Learning in Risk Management: A Game-Changer for Prop Trading, https://itsupplychain.com/machine-learning-in-risk-management-a-game-changer-for-prop-trading/

この記事は、投資助言ではありません。